Полагаться на ChatGPT - рискованное дело

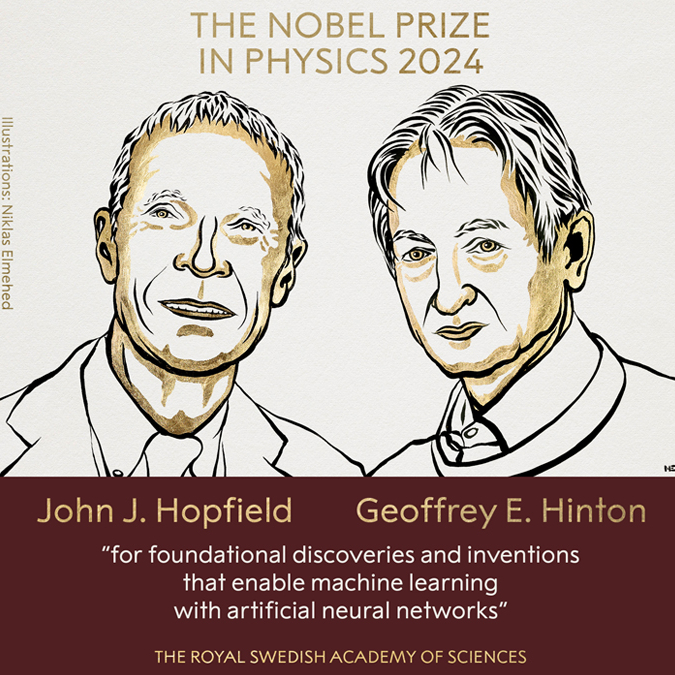

Системы генеративного искусственного интеллекта (ИИ) действительно демонстрируют впечатляющие результаты в различных областях, однако недавние исследования ставят под сомнение их способность к целостному пониманию мира и реальных правил, которые его регулируют. В частности, исследование, опубликованное в базе данных препринтов arXiv, проведенное учеными из Массачусетского технологического института, Гарварда и Корнелла, выявило некоторые серьезные ограничения больших языковых моделей (LLM), таких как GPT-4 и Claude 3 Opus от Anthropic.

Исследователи обнаружили, что, несмотря на высокую точность в формулировке пошаговых инструкций, LLM не способны создавать адекватные модели, которые бы точно отражали реальность. Например, когда им было поручено предоставить инструкции по вождению в Нью-Йорке, результаты были почти идеальными с точки зрения формата и структуры. Однако, когда ученые проверили карты, использованные в качестве основы для этих инструкций, они обнаружили, что многие из указанных улиц и маршрутов просто не существуют. Это подчеркивает важный аспект работы LLM: они могут генерировать текст, который выглядит правдоподобно, но не обязательно основан на реальных данных.

Более того, когда в инструкции вносились изменения, например, из-за закрытых улиц или необходимости объезда, точность указаний, предоставленных LLM, значительно снижалась. В некоторых случаях это приводило к полному провалу в предоставлении адекватной информации.

«Удивительно насколько ухудшилась производительность после того как мы добавили объезд. Если закрыть всего 1% возможных улиц, точность немедленно падает с почти 100% до всего лишь 67%», — заключает исследователь из Гарварда и ведущий автор Кейон Вафа.

Читайте также

Популярное

Мозг новорожденных чувствует ритм, но не мелодию

Загадочная болезнь в Конго

Почему мы снова толстеем после похудения?

Миссия "Хаябуса-2" и неожиданная находка

Инопланетяне могут путешествовать на звездах

Свет - это частица или волна?